第一三共が目指したデータ分析基盤の“理想形”とは? 構築までの苦悩と道筋を語る

第一三共は中核事業領域のシフトに伴い、統合的なデータ分析の対応が課題となっていた。全社データ分析基盤構築に踏み切ったが、さまざまな要件をクリアする必要があった。構築までのプロセスと苦悩を担当者が語った。

製薬企業の第一三共は、第4期中期経営計画(2016〜2020年度)で、事業の中核となる疾患領域を『循環器』から『がん』へとシフトする方針を掲げ、2025年に向けて製品の研究開発から販売までのバリューチェーン全体にわたる大きな転換を進めているところだ。

その中で、がん領域における高度かつ統合的なデータ分析の対応が重要な経営課題となっていた。また、分析部門においても、プログラマーの人材不足やデータの分散管理、データガバナンスなどデータ利活用に関するさまざまな課題を抱えていた。こうした課題を解決するためには、全社的なデータ分析基盤が必須になると同社は考えた。第一三共の上野哲広氏(DX推進本部 DX企画部 DX企画グループ長)が、全社データ分析基盤構築に着手した背景と構築までのプロセス、足かせとなった問題について語った。

8つの理想をかなえるために第一三共が選んだ道

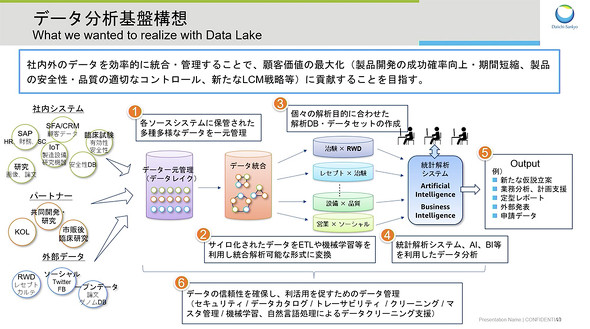

新たなデータ分析基盤では、「社内外のさまざまなデータを効率的にデータレイクに統合、管理し、先進技術を用いて分析することで、顧客価値の最大化(製品開発の成功確率の向上と期間短縮、製品の安全性と品質の適切なコントロール、新たなLCM戦略など)に貢献する」ことを目指し、システム構想を練っていった。しかし、データ分析基盤の構築に当たって、プラットフォームのテクノロジーや分析技術、コンプライアンスに関して多種の課題に直面した。

まず、プラットフォームの評価と分析技術に関するPoC(概念実証)を、IT部門とデータサイエンス部門の協働で実施した。プラットフォームについては、技術要件やセキュリティ要件への適合性を複数製品に対して評価し、分析技術のPoCでは、ノンプログラミングツールによる臨床データの統合分析の実現可能性および効率性を検証した。

その結果、全社データ分析基盤のプラットフォームとして「Amazon Web Services」(AWS)の採用を決断した。最終的にAWSを選択したポイントについて上野氏は、環境面では「自社システムの稼働実績」「コンプライアンス」「拡張性」「グローバル対応」を、サポート面では「先進技術の導入サポート」「運用サポート」「コミュニティー」「外部連携」の8点を挙げる。

「この中でも、最も大きな決め手となったのが、環境面の『自社システムの稼働実績』と『コンプライアンス』の2つです。当社では、すでに基幹業務システムや他の業務システムをAWSで稼働した実績があります。コンプライアンスについても、薬事規制(GxP:Good x practice)要件やコンピュータ化システムバリデーション(CSV)ガイドラインへの対応実績が十分にありました。また、当初からグローバル展開することを計画していたため、海外関係会社やパートナーとの連携が容易であった点もアドバンテージになりました」(上野氏)

AWSとサードパーティーのツールをどう組み合わせたのか

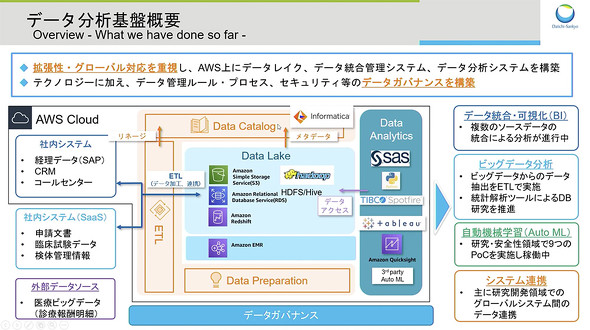

では、AWSをプラットフォームとして、実際にどのようなデータ分析基盤を構築したのか。新たなデータ分析基盤では、拡張性とグローバル対応を重視し、AWSにデータレイク、データ統合管理システム、データ分析システムを構築したという。

「AWSにデータレイクを作り、そこにデータを入れるだけでは分析基盤にはなりません。データ統合、加工、連携のためのETL(Extract、Transform、Load)や、データ管理のためのデータカタログ、ビジネス部門でも容易にデータ加工ができるData PreparationなどのツールをAWSに導入しました。また、データ分析システムには、『SAS』や『TIBCO Spotfire』『Tableau』『Amazon QuickSight』、サードパーティー製の自動機械学習ツールなどを導入しています」と説明する。

特徴的なのは、データレイクの構造だ。AWSのデータレイクは、複数のシステムで構成されており、データの内容に応じて、利用するシステムを使い分けている。例えば、フラットファイルは「Amazon Simple Storage Service」(Amazon S3)、構造化データは「Amazon Aurora」、大規模データは「Amazon Redshift」、分散処理が必要なデータは「Hadoop」に格納される。

さらに同社では、データ管理および分析の品質管理の観点から、データレイク全体を論理的に3つの領域に分離した。「Original Area」には、ソースシステムからの元データを保存する。「Work Area」には、加工中、または分析プロセス検討中のデータを保存、「Finalized Area」には、分析準備が完了したデータを保存している。各領域は、データオーナー部門やセキュリティレベルに応じてさらに細分化され、データカタログの管理単位となっている。

なお、データカタログやETL、Data Preparationといったデータ統合、管理システムには、Informaticaの製品を採用。これにより、データ資産の再利用、2次利用性の向上や、データ加工処理の部品化、テンプレート化による処理の効率化、データの信頼性、コンプライアンスの確保を図っている。さらに、「Amazon EMR」に構築することで、これらの効果に加えて、ビッグデータのデータカタログやデータ加工も可能としている。

ここで上野氏は、「今回のデータ分析基盤の構築では、こうした先進テクノロジーの活用だけでなく、データ管理のルールやプロセス、セキュリティなどのデータガバナンスの構築にも力を注ぎました」と強調する。

具体的には、薬事規制や個人情報保護などのコンプライアンスを順守するための承認プロセスを構築。運用プロセスに加えて、プラットフォームやデータ統合、管理ツールの機能による技術的なコントロールを実装している。また、薬事規制対象業務に利用するためにプラットフォームのCSVを実施。グローバル展開を想定して、日欧米の信頼性保証部門がレビューし、承認した。さらに、プラットフォームでの規制対象業務や外部への発表を伴う分析については、分析案件ごとにバリデーション計画を作成し、個別にCSVを実施した。

データ分析基盤の構築によって生み出された3つの成果

こうしてAWSをプラットフォームとして構築された第一三共の全社データ分析基盤は、2020年から運用を開始し、さまざまなシーンで同社のデータ利活用を促進させている。今回のセッションで上野氏は、3つの代表的な活用事例を紹介した。

まず、1つ目は、医療情報データベースのビッグデータ分析だ。薬の効果、安全性の分析のためにRWD(リアルワールドデータ)を活用し、データ分析基盤によって迅速かつ柔軟な分析を実現した。データは、メディカル・データ・ビジョンから約1TB、100億レコードの膨大なRWDが、Amazon Redshiftのスナップショットで毎月納品され、再構築することなく直ちに利用できるという。また、Amazon RedshiftとAmazon EMRを利用することで、大容量データのカタログ化および加工を可能とする。

2つ目は、医療機関から要請された情報を提供するために、複数の臨床試験の構造・非構造データを統合し分析するシステムだ。従来は、各種データや報告書などを個別に確認していたが、この統合分析システムにより、情報提供時間を大幅に短縮できる。また、新しい試験データの追加も容易に行うことが可能で、データのトレーサビリティーはETLとデータカタログにより可視化する。同システムは、現在、バリデーションを実施している段階で、近いうちに実運用を開始する予定だ。

3つ目は、複数のグローバルシステムとの連携を、データ分析基盤を利用して実現した事例だ。これまでは、システムごとにデータ連携を行っていたが、データ分析基盤をハブにすることで、全システムのデータ連携処理を集中化した。これにより、品質の高いデータを関係システムに速やかに同期することが可能となり、意思決定の質や、スピードを向上させた。また、共通のETLシステムにより、プロセスが可視化され、グローバルでのシステム開発の効率、保守性も大幅に改善したという。

今後の展望について上野氏は、「全社データ分析基盤の構築により、これまでIT部門中心だったデータ利活用が、ビジネス部門へも拡大しつつあります。今後は、ビジネス部門が、コンプライアンスにのっとり、自ら柔軟にデータ利活用できるよう、データガバナンスや高度な分析支援、教育プログラムなどをCoE(Center Of Excellence)で提供し、データの民主化の実現を目指していきます」との考えを示した。

本稿は、「AWS Summit Online 2021」における、第一三共の上野哲広氏における「第一三共の全社データ分析基盤〜データ利活用の促進をめざしてデータレイクを構築〜」の講演を基に、編集部で再構成した。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

中部電力「カラスの巣見守り」の裏にある巨大データ分析基盤の秘密

中部電力「カラスの巣見守り」の裏にある巨大データ分析基盤の秘密

制御系も基幹系も、外部データも丸ごと分析するためのデータ基盤を持つ中部電力。カラスの営巣を見守る裏側で、巨大なデータ分析基盤を運用する。一体何をどう使っているのか。 トレンドマイクロがAWSを「攻撃」? サーバレスセキュリティの考え方とは

トレンドマイクロがAWSを「攻撃」? サーバレスセキュリティの考え方とは

トレンドマイクロがAWS Lambda を「攻撃」してみた――。既存のものと異なるIT環境をどう守るべきか、セキュリティベンダーが攻撃者の視点から解説した。 20年たってこう変わった、SAPのCRM、BI、ERP最新事情

20年たってこう変わった、SAPのCRM、BI、ERP最新事情

SAPによると、国内企業のCRM、BI、ERPのシステム対応にはまだまだ課題点が残るという。それぞれの分野における“マズイ”点を指摘するとともに、SAPのSaaSの特徴を深掘りする。