よく分かるAI導入のポイント、事例と「Microsoft AI Platform」の今を学ぶ:イベントレポートアーカイブ(2/2 ページ)

業務の一部にAIを利用して効果を挙げた2つの事例

畠山氏は既に提供されているAIを活用するには「どこにAIを適用すれば効果が高まるか」を考えることが重要だとし、次の2つの事例を紹介した。

コンバインへのAI適用で農薬を大幅削減

1つはレタス農家がコンバインで収穫する際の雑草混入を改善した例だ。

従来は大量の農薬を使って雑草を減らすことで収穫効率を上げてきた。その発想を変え、コンバインにカメラとオフラインで利用できるAIを搭載し、雑草とレタスを自動分別する仕組みを導入したところ、農薬の使用量を大幅に削減できた上、オーガニックの農産物として付加価値を付けることができたという。AIの適用領域はごく限定的であるにもかかわらず、大きな導入効果をあげることができたわけだ。

字幕と翻訳の業務コストと時間を大幅削減

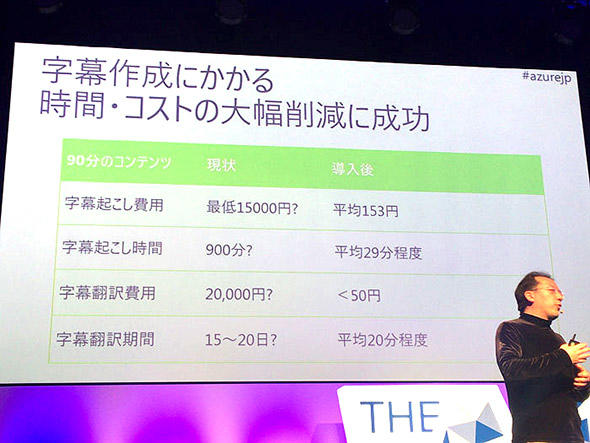

もう1つの例は、北海道大学大学院工学研究院工学系研究教育センターでのeラーニングへの適用だ。同大学院では海外からの学生に向け、動画コンテンツに日本語や英語の字幕を挿入していた。これまで翻訳は外注し、字幕を付ける作業は職員やアルバイトが行っていた。

その2つの作業にAI(「Microsoft Translator」と「Media Indexer」)を利用した。

字幕作成作業の自動化効果はめざましく、人手では、90分の動画に15時間かかっていた作業が、約30分の1(90分動画に平均29分程度)に短縮できた。金額で見ると、最低1万5000円かかっていた作業が、平均153円になったという。

翻訳作業はさらに劇的な効果を見せた。従来2万円かかっていた費用が50円以下になり、15日から20日の期間を要していたのが平均20分程度にまで激減した。つまり人の作業に比べ、コストを最大400分の1に、時間を1000分の1程度にまで圧縮できたというわけだ。しかも70カ国語に対応できるのも、大きな利点だ。

ただし、完全にAIに作業を任せられたのかといえば、そうではないだろう。AIの自動認識や翻訳などの精度は100%ではないからだ。これについて畠山氏は「精度うんぬんではなく、大量のデータを一度に処理できることが重要。AIで完璧な結果が出ないからと否定するのでは発展の芽を摘むことになる。ディープラーニングは急速な成長の真最中。精度が完璧でないからダメだというのは利用者も開発者の双方が成長しない」と指摘した。どんな企業にも、人の作業量の多さがネックになっている業務はたくさんあるだろう。畠山氏は「いま一度、現在の業務を洗い出して、AI適用がどんな効果を生むかをシミュレーションすべき」だとアドバイスした。

JFK暗殺関連の機密文書解読に見る、デジタル入力の変革

Microsoftでは2017年11月に公開された元米大統領ジョン・F・ケネディに関する約3万ページもの機密文書を、デジタル化してキーワード検索やノーテーション付加などを可能にする取り組みを行っている。テキストからキーワードを抽出し、単語間の関連性の探索や付属情報の付加といった作業をCognitive Servicesで行っているのが特徴だ。最終的には人間の解読が必要だが、3万ページに及ぶ膨大な文書のどこに何が書いてあるかを整理しなければ、全体の内容把握がすぐにはできない。そこで紙の文書をデジタル化し、OCRで読み取り、AIなどで分析して、解読しやすくしたわけだ。その取り組みや、利用しているコードはWebサイトに公開している。

この例が示唆しているのは、文書が何らかの形でデジタル化されていれば、それを解析したり付随する情報を後から付け加えたり、より内容把握を深化させるための工夫ができるということである。文書への属性設定やタグ付けなどのように、人でなければできないと思われてきたこともAIで自動化できる可能性が高い。また同様に、文字情報よりも圧倒的に情報量の多い写真データもAIによる解析を前提にすれば利用範囲は広がる。

ドメイン/目的特化AIの使い分けが大事

次に畠山氏は「相撲」の写真を示しながら説明した。誰が見ても土俵の上で四つに組んだ力士の写真にしか見えないが、恋愛小説を学習したAIエンジンを用いて写真のキャプションをつけると、「裸の人物が抱き合って肩にキスしようとしているシーン」になってしまうという。AIエンジンは目的に合わせて使い分ける必要があるという典型例だ。

これは裏を返せば、特定の目的に特化したAIエンジンを適切に選べば、より正確な結果が得られるということでもある。GoogleやFacebookなどはオープンドメインの、つまり何にでも汎用的に使えるAIを作ろうとしているが、それにはまだ時間がかかる。現在は特定の目的のAI機能を組み合わせて使う必要がある。「Azure Data Lake」のように複数のCognitive機能を備えたサービスは出てきており、サービスにやってもらいたいことをクエリ化して渡すだけで、一度に複数のAI機能を利用した大量データ処理が可能になっている。

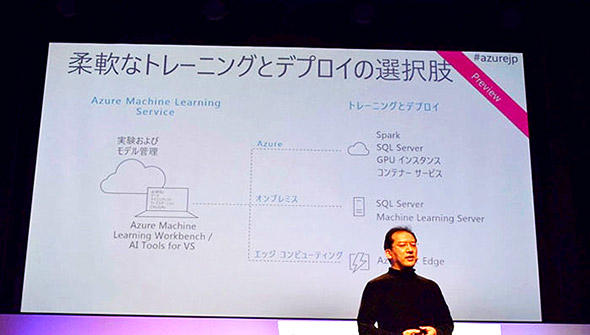

自社オリジナルの機械学習+運用ができるサービスも登場

畠山氏はまた、「道具の良しあしの見極めは重要。利用できるAIを適切に適用するべきだ。しかし、自分でエンジンを作ることもできる。そのために、データからモデルを作る学習プロセスはもちろん、実運用までをカバーする初めてのサービス『Azure Machine Learning 』サービスがディープラーニング開発者の仕事を軽減できる」と話す。開発に関わるサーバやエッジ端末に必要なモジュールは、Dockerを利用したコンテナとしてデプロイできるのが特徴の1つ。「これからはエッジ(組み込み機器)の重要性が増す。『Azure IoT Edge』はコンテナベースのモジュール群からなり、デバイス管理も含めてIoT活用に貢献する」と言う。機械学習は学習を繰り返すほどに賢くなる。そのためには多様なサーバやデバイスで利用できることは重要だ。

最後に畠山氏は「ルールベースで作られたビジネスに、少しディープラーニング技術を加えることで、ちょっと便利なアプリケーションが生まれる。しかしちょっとの便利が、前述事例のように劇的なコスト削減や時間短縮などの絶大な効果を生むことがある。Microsoftはその事例を公開している」と紹介しセッションをくくった。

Copyright © ITmedia, Inc. All Rights Reserved.

製品カタログや技術資料、導入事例など、IT導入の課題解決に役立つ資料を簡単に入手できます。

- リチウム電池も終了か 40年眠っていた、充電を爆速化する「古くて新しい電池」って?:866th Lap

- AIに書かせたコードはどこが「危ない」? プロがガチ採点して分かったこと

- 「国家資格で食える」はもう古い? 5年分の調査で見る、AWS、セキュリティに続く“次の資格”

- AIアプリ開発「Dify」って結局何がすごいの? 機能、料金、ユースケースを徹底解説

- PC高騰、いつまで続く? IDCアナリストに聞く値上げ時代の賢いPC調達術

- 正規認証が悪用される? Microsoft 365の権限を奪う「デバイスコードフィッシング」とは

- 極悪なウソつきはGeminiかGPTか? 4つのAIモデルをガチ対戦させてみた結果:865th Lap

- 資生堂や小田急リゾーツが不正アクセスを受ける、新電力も

- ソフトバンクから8000人以上の情報漏えい、2026年版の10大脅威発表

- Excelが強すぎる BI導入済みなのに表計算ツールを使う企業がかなり多いワケ