課題と市場変遷から導き出すBI強化の方向性:すご腕アナリスト市場予測(1/3 ページ)

データ分析に関するプロジェクトが多く立ち上がる中、BIやDWHに触れた経験を持つ人も多いはず。そこで今のBIについて振り返りながら、今後強化していくべき方向性について考えたい。

昨今では、企業にもたらされるデータが次のアプリケーションを考えるうえでも重要になってきており、データを分析するプロジェクトなどでBIやDWHに関連した取り組みに関わったことのある方は多くいるはずだ。そこで今回は、BIにおける現状の課題から現在のBIトレンドの変遷を見ていきながら、今後BIをどう強化していくべきなのかという視点で、BIの今後について考えてみたい。

アナリストプロフィール

堀内 秀明(Hideaki Horiuchi):ガートナー ジャパン リサーチ&アドバイザリ部門

アプリケーションズ ジャパン マネージング バイス プレジデント

日本における、エンタプライズ・アプリケーション領域をカバーするチームの責任者。チームのカバー領域には、ERP、CRM、コラボレーション、アプリケーション開発、アプリケーションの統合とアーキテクチャ、データ・マネジメント、BI/アナリティクスが含まれる。加えて、BI/アナリティクス領域のアナリストを兼務しており、BI ツールなどのデータ分析・活用を行うソフトウェアに関する市場動向調査、当該ソフトウェア製品やベンダーの選定における情報提供と助言、ならびにデータ利活用に関するベスト・プラクティスの調査と助言を行っている。慶應義塾大学理工学部卒。

BIにおける典型的な課題

これまでのBIにおける特徴

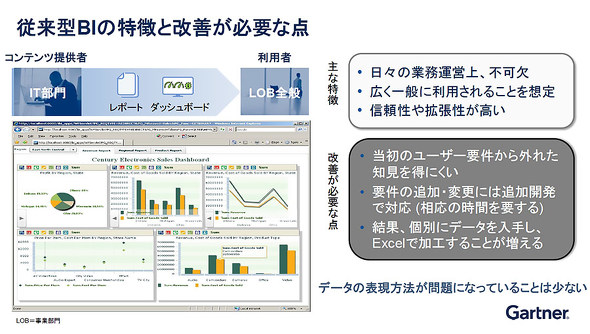

まずは現状のBIにおける課題について見ていこう。一般的なBIの場合、帳票をはじめとした各種レポートやダッシュボード画面はIT部門が作成し、利用者である各事業部門、いわゆるLOBが活用できるようになっているケースが多い。BIの画面を見てみると、ダッシュボードとして構成されているものの半分程度は、Excelのような画面でグラフが表示されていることが多くみられる。

これまで導入されてきたBIの主な特徴は、日々の業務運営上不可欠なものを分析することに主眼が置かれており、どんな業務で使うのか、週次や月次といったどんなタームで必要なのかといった要件定義をしっかり行ったうえで導入されるケースが多い。

また、従来型のBIは情報民主主義の名のもと、広く一般的に利用することを想定して作られてきた。だからこそ、アクセスする人ごとにデータを出し分けしたり、1000人がアクセスしてもレスポンスが低下しないようなアーキテクチャが採用されたりなど、信頼性や拡張性が高いシステムが求められてきたのだ。

BIにおける課題とは?

これまで主流だったBIの特徴を見てきたところで、具体的にはどんなことが課題になってくるのだろうか。前述したとおり、要件がはっきりした形でBIが構築されていることで、当初のユーザー要件から外れた知見を得るのが難しいのは当然だろう。例えば売上が落ち込んでいる要因を調べる際に、これまで見てこなかった地域別に分析しようとしても、当初の要件には含まれていないため、追加での開発を余儀なくされる。しかし、開発メンバーが常に追加案件に対応できる状態にあるわけではなく、厳しいときには来期の開発計画に組み込まれてしまうなんてことも。それでは必要な分析が1年後にしかできないことになり、とてもじゃないが来年まで待つということは現実的に難しいだろう。そこで、情報システム部門に個別のデータだけ欲しいと依頼し、Excelを用いて自分自身で加工して分析していくことになるわけだ。

ここで重要なのは、Excelのようなデータの表現方法に問題があるのではなく、そもそもデータの整備不足が大きな課題の根幹にあるという点だ。BIやDWHといったデータ活用のプロジェクトは、例えばERPのような特定のアプリケーションを導入した後に検討される流れが少なくない。この場合、分析対象となるデータそのものはあるものの粒度が荒いことも。例えば何か商品の動きを分析する際に、パレット単位では把握できるが、アイテム単体での情報が足りないといったイメージだ。そもそも粒度が荒いデータは詳細に分解することが難しい。

また属性情報が十分でないこともある。本来なら基幹システム側で持つべき情報も、属性情報を詳細に保持するほど開発工数がかかることになり、分析を意識していれば必要になる情報も開発段階で削られてしまい、後から分析できないといった事態も起こり得る。

情報の鮮度という意味でも問題になりやすい。いわゆるバッチ処理の弊害ともいえるが、処理を締めるタイミングが月次だと、当然ながらオペレーション自体も月次に合わせた動きになる。本来であれば週次で情報が分析に必要なのに、月次のバッチ処理にしか対応していないケースでは、どうしても情報の鮮度が落ちてしまう。

このように、データそのものは存在しているように見えるものの、分析する側からするとないに等しいともいえるのだ。

さらに、分析を意識していないと業務ごとのシステムにデータが散在してしまうことが多く、これらを分析できる形にデータ統合していくこと必要になる。これも、当初からデータ統合は想定されていないため、マスターが不一致でコード体系もバラバラ。何かの項目を軸に統合することになるが、それ以降も同じ方法を踏襲していく必要があり、運用面では負担になる場面も。

データ品質の低下にも注意が必要だ。システム稼働時はよかったものの、年月を経るごとに環境変化が起こり、情報の品質が低下する恐れも出てくる。DXなど新たな取り組みを進める際には分析が欠かせないが、そのためのデータ統合をどこまで行うのかも十分検討する必要がある。

そんなデータの整備不足が課題となり、結局データを個別に入手し、Excelで加工するという機会が増えてしまう。実は、これから4年経っても臨機応変な分析には多数のExcelが使われているという予測をガートナーでは立てている。ただし、Excelが悪いというわけではないため、今後もExcelが残ることを前提に、よりよりインサイトが得られるよう何ができるのかを積極的に考えていく必要がある。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製品カタログや技術資料、導入事例など、IT導入の課題解決に役立つ資料を簡単に入手できます。

- リチウムイオン電池も終了か 40年眠っていた、充電を爆速化する「古くて新しい電池」って?:866th Lap

- AIに書かせたコードはどこが「危ない」? プロがガチ採点して分かったこと

- 「国家資格で食える」はもう古い? 5年分の調査で見る、AWS、セキュリティに続く“次の資格”

- ある工場で「週休3日制」が受け入れられなかった意外なワケ

- AIや派手な機能よりもグループウェアに望む2つのこと【ユーザー調査】

- PC高騰、いつまで続く? IDCアナリストに聞く値上げ時代の賢いPC調達術

- 「バックアップないけど復旧して」 情シスを“便利屋”として使い倒す現場の実態

- AIアプリ開発「Dify」って結局何がすごいの? 機能、料金、ユースケースを徹底解説

- AI時代にサイバーセキュリティはどう変わるか どの企業でも必要な対策のポイントとは

- Notion導入で生成AI活用のナレッジ基盤を構築 従業員の情報意識にも変化