生成AI活用を「セキュリティファースト」で進めるための6つのステップ

企業が生成AIを導入する際の課題は多い。「従業員の多数が利用するとなると情報漏えいが不安だ」「権限のない従業員に機密情報を勝手に利用されたくない」――このような不安をどのように解決できるのか。Microsoftが勧める方法を紹介しよう。

社内で使う生成AIを選定し、導入し、運用する際にはさまざまな不安がある。導入担当者にとっては、自社の機密データが外部に流出することはないか、社内において、権限外の利用者が生成AIを利用することで、意図せず特定の機密情報にアクセスしてしまうリスクもある。

このような懸念に対応するため、現在多くの生成AIは、機密データの保護や権限外のリソースへのアクセス禁止といったデータガバナンスの原則を積極的に取り入れている。

生成AI導入はセキュリティファーストで

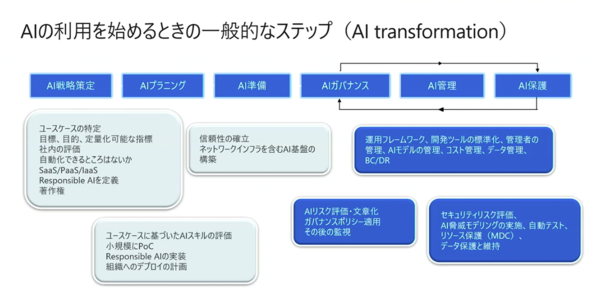

記事の後半では、不安を解消するための具体的な方法を紹介する。その前に、生成AIに対する考え方を見直し、保護に至る準備から利用後の運用サイクルまでを、6つのステップに分けて再考してみよう(図1)。

6つのステップは2つの段階に分かれる。まずは、生成AIの利用を始める前の「AI戦略策定」「AIプランニング」「AI準備」だ。

生成AIの利用を開始した後は「AIガバナンス」「AI管理」「AI保護」の3ステップをサイクルで回す必要がある。図1の6ステップの内容をまとめると次のようになる。

ステップ1 「AI戦略策定」

ここで重要なことはユースケースの特定の他、目標や目的、定量化可能な指標の設定、社内の評価、自動化可能な箇所の探索、SaaS/PaaS/IaaSのどれを選ぶか、自社における「Responsible AI」(責任あるAI)の定義、著作権に関する検討といった事項だ。従業員にどのように生成AIを利用してもらうべきなのかを見極めることが目的だ。

ステップ2 「AIプランニング」

ユースケースに基づいたAIスキルの評価と小規模な概念実証(PoC)、Responsible AIの実装、組織へのデプロイの計画といった作業を進める。

ステップ3 「AI準備」

基盤を構築する。ネットワークインフラを含む生成AIの基盤を構築する場合は、信頼性の確立を忘れてはならない。

ステップ4 「AIガバナンス」

このステップは生成AI利用サイクルの始まりだ。先ほど説明した通り、ステップ4〜6はサイクルとして繰り返し実行する必要がある。AIガバナンスは、生成AIのリスク評価や文章化、ガバナンスポリシー適用、その後の監視の仕方を整備することが目的だ。リスク評価については米国国立標準技術研究所(NIST)のAIリスクマネジメントフレームワーク(AI RMF)などの基準、規約の利用を推奨する。

ステップ5 「AI管理」

「Generative AI Ops」や各業界規約、Microsoftの規約などを利用した運用フレームワークの他、開発ツールの標準化や管理者の管理、生成AIモデルの管理、コスト管理、データ管理、事業継続性/災害復旧(BC/DR)が含まれる。

ステップ6 「AI保護」

セキュリティのリスク評価や生成AIの脅威モデリングの実施、自動テスト、リソース保護(MDC)、データ保護と維持といった作業がある。

リスク評価には、MITRE(ATLAS(Adversarial Threat Landscape for Artificial-Intelligence Systems)やNIST規約を活用できる。また、経済産業省と総務省、金融庁からは、2024年春頃に関連規約が公表されており、これらにはデータセキュリティやデータガバナンスに関する記載が含まれている。さらに、脅威モデリングにも参考となる規約がある。加えて、生成AIそのものを保護する手段として、Microsoftの「Defender for Cloud」などのソリューションも利用可能だ。

生成AI導入と利用に関して6つのステップを踏む際に大事なのは「セキュリティファースト」で始めることだ。生成AIからの出力結果やレスポンス品質はもちろん重要だが、セキュリティが守られていればどのように利用されても大きな問題は起きないだろう。

データ保護とデータガバナンスに残る3つの課題

生成AIのセキュリティは非常に幅広い分野にわたる。AIモデルそのもののセキュリティはもちろん、ポリシーとガイドラインの策定、運用およびモニタリングの強化、生成AIの信頼性と安全性の確保といった領域での取り組みが不可欠だ。これらは多くの導入事例においても検討が進められている。ここではさらに重要なポイントとして、データ保護とガバナンスについて取り上げる。具体的な検討事項は3つある。

(1)データ分類と保護

社内には数千万から数億に及ぶ膨大なデータファイルが存在するとされ、多くの企業が外部へのデータ流出リスクを懸念している。例えば、営業部の従業員が生成AIを操作した結果、人事部のデータベースから情報が漏えいしてしまうような状況は避けたいところだ。また、法務部では生成AIを法務に関する処理のみで運用したいというニーズもある。数多くのオフィスツールに散在するデータをどのように分類、管理するかは、最初に取り組むべき重要な課題と言えるだろう。データ保護に関しては、暗号化やアクセス制御を導入することで、外部へのデータ流出を防ぐ仕組みを構築する必要がある。

(2)データガバナンス

何らかのセキュリティインシデントが発生した場合、企業として説明責任を果たす必要がある。これは各種規約にも詳しく記されていることだ。ガバナンスの要求に応えるには生成AIの利用記録を保存しておく仕組みが必要だ。

(3)リスクの最小化

許可された限られた人のみがデータを利用できる仕組みを構築することが不可欠だ。しかし、「Microsoft Copilot」では、ユーザーがアクセス可能な全てのデータが生成AIのアクセス対象となる。そのため、長年蓄積されてきたデータの中には、ユーザーが意識していなくても、何らかの理由で既にアクセス権限を失っているものが含まれている可能性がある。このようなリスクを回避するため、多くの企業はデータの公開範囲を可能な限り最小化する方針を採用している。

3つの課題を解決するには

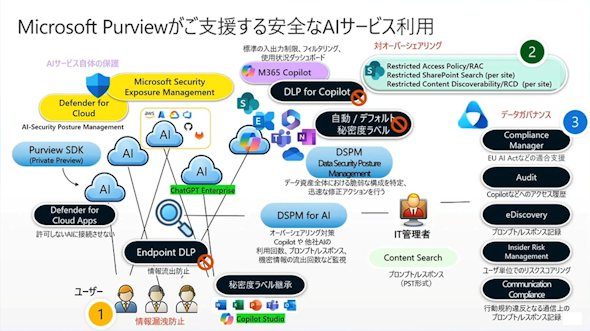

これら3つの課題を解決に導くために、Microsoftは「Microsoft Purview」というブランドで各種のツールを提供している。これはデータセキュリティとデータガバナンスのためのツール群で、3つの課題に対応する次のような機能を備えている(図2)。

(1)データ分類と保護

データオーバーシェアリング対策やデータ漏えい防止(DLP)、暗号化、情報の分類(自動ラベル適用、Copilotや「ChatGPT」のレスポンスにラベルを継承させる機能)、コミュニケーションの監視(メールやTeamsの会話の行動規約違反などの監視)

(2)データガバナンス

内部不正の発見と対策(適正な業務と不適正な行動の切り分けなど)、監査(ファイル操作から管理者の記録まで全ての記録を取る)、記録した情報を検索してエクスポートし、行動の証跡保全を担う「eDiscovery」、期間を定めたデータの保管(古いデータは隔離するなどのコントロールを実行)、コンプライアンス関連法令・規約準拠(AI RMFやEUのAI Actなどへの合致状況の出力)

(3)リスクの最小化

「Data Security Posture Management」(データ資産全体における脆弱《ぜいじゃく》な構成を特定し、迅速な修正アクションを実行)、「DSPM for AI」(オーバーシェアリング対策、Microsoft Copilotやその他の生成AIの利用回数、プロンプトレスポンス、帰一情報の流出回数などを監視)、非承認の生成AIサービスへの接続拒否(特定の承認された生成AIサービスだけを利用する)

不適切なプロンプトを検出する

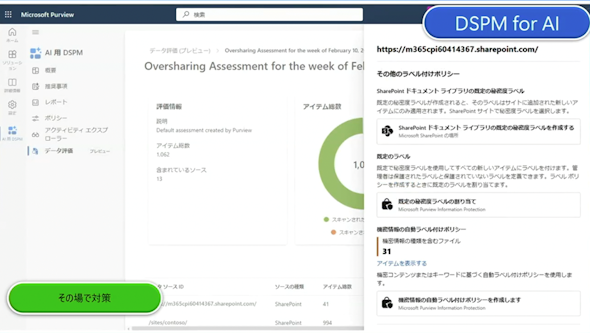

(3)で述べたリスクの最小化について、さらに詳しく説明しよう。ここではセキュリティ強化を目的として、Microsoft Purviewに含まれる2つのツール、DSPM for AI(Data Security Posture Management for AI)とData Security Posture Managementを使う。

DSPM for AIはMicrosoft Copilotや「Google Gemini」「Perplexity」などの生成AIサービスの使用状況を可視化するツールだ。生成AIサービスへのアクセス数やプロンプトに含まれる機密情報などをレポートで把握でき、特にMicrosoft Copilotについてはポリシー違反プロンプトとレスポンスを取得することもできる。

行動規約に反するような不適切なプロンプトを検出して、管理画面で表示したり、対策ポリシーを作成したりできる。内部統制対策ツールの「Insider Risk Management」と併用すれば、生成AI利用のルール違反をした人物の特定や違反回数、DLPによる遮断回数なども分かり、データ面と人の面でのリスク分析が可能だ。

データアセスメント機能を使うと、Microsoftが提供するクラウドベースのコラボレーションプラットフォーム「SharePoint Online」(上位100サイト)におけるファイルのオーバーシェアリングを発見して、対策ポリシーを設定できる。対策では次に紹介するData Security Posture Managementを利用できる。

情報が公開されていないかどうかを確認する

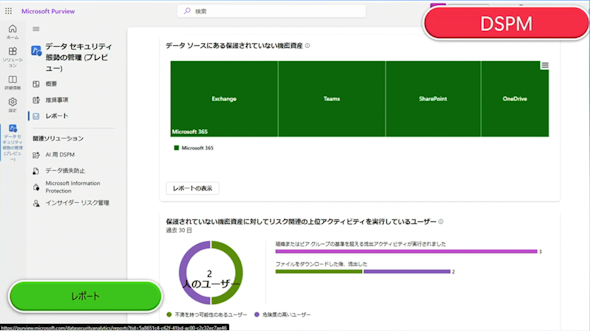

社内の情報がどの程度外部に公開されているのかを確認するツールがData Security Posture Managementだ。

対象は生成AIによるものだけではない。「Microsoft SharePoint」「Microsoft Exchange Online」「Microsoft OneDrive」「Microsoft Teams」などでの情報公開の様子を可視化できる(現在はパブリックプレビュー)。

先に紹介したDSPM for AIがAIサービスに特化して可視化するのに対し、Data Security Posture Managementは、データ資産全体を対象とした脆弱な構成の特定を可能にし、迅速な修正アクションを支援する。さらに、ワンクリック、または数クリックで対応ポリシー(DLPやInsider Risk Management)を作成でき、保護されていない機密ファイルの流出状況やチャネルごとの未保護ファイル数などをレポートとして出力することも可能だ。

ヒストリカル表示機能を活用することで、秘密度ラベルが適用された1週間ごとの資産割合を過去1カ月にわたりグラフ化し、時系列でセキュリティ状況の変化を把握できる。これにより、セキュリティ強化の過去と現在を容易に比較することが可能だ。

Microsoft Purview製品に共通する特徴として、セキュリティ管理者向けの生成AIである「Security Copilot」との統合が挙げられる。これにより、管理者は日本語を含む自然言語でデータセキュリティに関する問い合わせが可能になり、膨大なセキュリティ関連データの分析や評価にかかる負担を大幅に軽減できる。

本稿で紹介したツールは、生成AIの利用時に生じるリスクの最小化に貢献し、セキュリティ強化の状況、つまり脅威への耐性レベルを継続的に把握することが可能だ。また、高リスクで対策が必要な箇所を特定し、優先的に対応することでシステム全体の安全性をさらに向上できる。

安全な生成AIの利用には今回紹介した内容以外にも検討が必要な事項は多い。まずはリスクの最小化を実現してからデータガバナンスを徹底していくと良いだろう。こうしたツールも利用したセキュリティファーストでの生成AI導入・活用の最適の道を探していただきたい。

本記事は2025年3月13日に開催された「Microsoft Security Forum 2025 Online」の「Microsoft 365 Copilotや他社AIサービスを安全に活用するためのデータセキュリティ」(日本マイクロソフト セキュリティ 小林伸二氏)の講演内容を編集部で要約・再構成したものです。

関連記事

Microsoftが語る セキュリティ運用を軽くする2つの方策とは

Microsoftが語る セキュリティ運用を軽くする2つの方策とは

企業に対するサイバー攻撃は質、量とも悪化する一方だ。セキュリティ人材が不足する中、運用負荷を下げつつ効果的な防御策がほしい。Microsoftが勧める2つの方法を紹介しよう。 生成AIと従業員のやりとりを“見張る”「AIファイアウォール」って何?

生成AIと従業員のやりとりを“見張る”「AIファイアウォール」って何?

生成AIの登場によって、企業が対策すべきリスクがさらに増えたといえるだろう。そんな中、生成AIの利用時にセキュリティやガバナンスを確保するための「AIファイアウォール」というものが、にわかにトレンドになっているらしい。生成AIと利用者とのやりとりを監視するというが、一体どのようなソリューションなのか。 「生成AIは安全ではない」 AIのセーフガードが突破される危険性

「生成AIは安全ではない」 AIのセーフガードが突破される危険性

個人的な利用とは異なり、企業で生成AIを利用する場合にはデータプライバシーや保護といった自社向けのセーフガードを構築する必要がある。企業は生成AIを利用する前にこのことを考慮できているだろか。そもそもセーフガードは機能するのだろうか。

Copyright © ITmedia, Inc. All Rights Reserved.

製品カタログや技術資料、導入事例など、IT導入の課題解決に役立つ資料を簡単に入手できます。

- リチウム電池も終了か 40年眠っていた、充電を爆速化する「古くて新しい電池」って?:866th Lap

- AIに書かせたコードはどこが「危ない」? プロがガチ採点して分かったこと

- 「国家資格で食える」はもう古い? 5年分の調査で見る、AWS、セキュリティに続く“次の資格”

- 正規認証が悪用される? Microsoft 365の権限を奪う「デバイスコードフィッシング」とは

- PC高騰、いつまで続く? IDCアナリストに聞く値上げ時代の賢いPC調達術

- AIアプリ開発「Dify」って結局何がすごいの? 機能、料金、ユースケースを徹底解説

- 会社の規則は穴だらけ? 誰も守ってくれない「無視されるITルール」【実態調査】

- 極悪なウソつきはGeminiかGPTか? 4つのAIモデルをガチ対戦させてみた結果:865th Lap

- 「RPAをお祭り騒ぎにはしない」三菱東京UFJ、RPAへの全力投球

- IT資格、給与アップや転職に本当に効果がある? 読者387人に人気資格を聞いた