法務に使える生成AIはどれ? デジタル庁の“法令クイズ”で4ツールをテストしてみた

デジタル庁が2025年10月初旬に「日本の法令に関する多肢選択式QAデータセット」を公開した。AIが法務部門の実務でどこまで通用するのかを測ることを目的としたこのデータを、「ChatGPT」「Microsoft Copilot」「Google Gemini」「Claude」に解かせ、その正確性を評価してみる。

法務の業務を効率化するために生成AIを導入する場合、どのツールを選べばいいのでしょうか。最も重要な選定基準は生成する回答の品質でしょう。法務部門においては、正確な法令知識があって、状況に応じて適切な判断ができてほしいものです。あまり的外れな回答をされると、むしろチェックに余計な時間がかかる可能性もあります。

そこで使えるのが、デジタル庁が2025年10月初旬に公開した「日本の法令に関する多肢選択式QAデータセット」(以下、法令QAデータセット)です。これは平易に言えば“法令クイズ集”です。同庁は公開の目的を「AIが法務部門の実務でどこまで通用するのかを測ること」としています。

今回はこのデータセットを「ChatGPT」「Microsoft Copilot」「Google Gemini」「Claude」に読み込ませて法令クイズを解かせ、その正確性を評価してみます。

どんなクイズが収録されている?

法令QAデータセットは「GitHub」で公開されています。出典を明記すれば商用利用も可能です。クイズは全140問収録されており、全て4択問題のため、誰でも採点できるようになっています。

収録されている問題を1つ見てみましょう。

金融商品取引法第5条第6項により、公益又は投資者保護に欠けることがないものとして内閣府令で定める場合に該当することを理由として、届出書提出外国会社が金融商品取引法第5条第1項の届出書に代えて提出ことができる書類を教えてください。

(a)第5条第1項の届出書に類する書類であって、届出書提出外国会社の本店所在地の母国語であるフランス語で記載されているもの

(b)外国において開示予定の参照書類であって、英語で記載されているもの

(c)第5条第1項の届出書に類する書類であって、英語で記載されているもの

(d)外国において開示が行われている参照書類であって、日本語で記載されているもの

答え:c

何となくでは答えられない難易度になっている印象です。今回はこのデータセットから正解データだけ削除して各種ツールに読み込ませ、以下のような指示をして問題を解かせました。

これは品質、性能テストです。添付のCSVは日本の法令に関する問題集(全140問)です。問題を読み込んで解答を生成してください。解答形式は以下の通りです。

解答 a a b a ...

解説

121:施行令2条の13第1号で法2条1項15号が特定有価証券と規定

122:施行令2条の8で社会医療法人債券を政令で定める

123:法172条の2第1項1号で株券の募集による課徴金は4.5%

124:法185条の22第1項1号で暗号資産関連金融指標を定義

…

複数パターンの指示を試してみましたところ、内容によって正答率は変わります。実際に製品選定でテストする場合は、このタイミングで「どんな指示をするのが最も出力品質を上げられるか」を探ってみるのもいいでしょう。正式に導入した際に、ユーザーに向けてガイドラインやテンプレートとして提供できます。

この後、4つのツールについて正答率を記載しますが、あくまで参考値としてください。

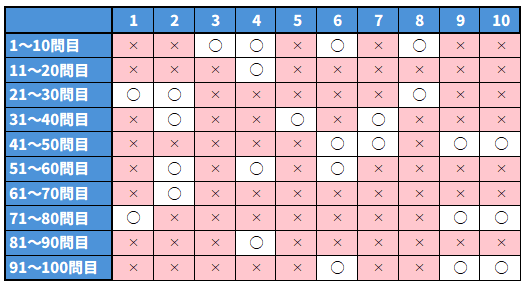

第4位 Gemini(2.5 Flash) 26点(100点満点)

もっとも点数が低かったのはGeminiでした。かなり点数が低いため、少しプロンプトを変えながら4回試しましたが、21点、21点、22点、26点とほぼ同じ結果でした。

簡単な解説も生成させた結果、多くの問題に「○○という法令により○○と規定されているため、選択肢○が正しい」と説明しています。しかしその内容が間違っています。

よく見てみると、回答と解説で選んだ選択肢が食い違っていたり、そもそも参照している問題がずれていたりと動作が不安定な印象でした。これはデータの形式の問題もあるかもしれません。デジタル庁が公開しているデータはCSV形式とJSON形式がありますが、特にCSVは構造を読み取りにくいのか生成が安定しません。

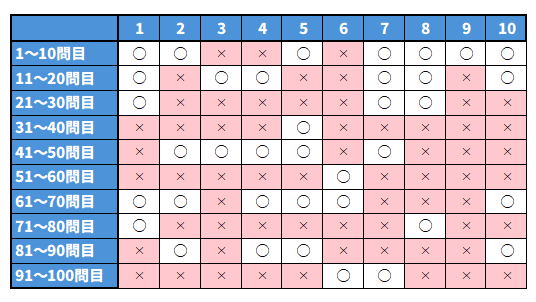

第3位 ChatGPT(GPT-5 Auto) 37点

次に低かったのがChatGPTです。こちらは素直に解答を生成しないことが多く、もっと点数が低くなったパターンもありました。37点を出した回では、ChatGPTのモデルが解答を直接生成していましたが、もっと低得点だったときには、特別な指示をしていないにもかかわらず、問題文と選択肢を分解して、含まれる単語の類似度を計算して選択肢を選んでいました。

今回は正解が分かっているため、ユーザーが正解率を高めるようアプローチできますが、ChatGPTを全面的に信用している状態で工夫なく使っていると、正解率37%の品質の解答を信じてしまう可能性があります。これはChatGPTが悪いというよりは、生成AIとの付き合い方が間違っている可能性や、プロンプトが適切でない可能性を検討した方がいいでしょう。

今回はテストしていませんが、こういったタスクならおそらくRAG(検索拡張生成)技術を使って、法令データベースを生成AIに接続して調整を繰り返すと品質を確保できるかもしれません。

第2位 Copilot(Smart) 62点

第2位はCopilotでした。ベースのモデルはGPT-5なので、モデルの性能はChatGPTと大きく変わらないはずですが、一気に点数が上がっています。Copilotはファイルの読み込みやテキストデータのコピーアンドペーストの挙動に癖がありますが、品質はそこそこです。

ここまでの2つと比べるとダブルスコア前後と高得点ですが、正答率62%はかなり不安な数字です。10回質問すれば4回は間違っている可能性があるわけですから、都度チェックする必要があり、業務効率を改善できるかは怪しいです。使い方としては「社内でこういう問い合わせがあった。私はこう考えるが、何か見落としている重要な要素や可能性はないだろうか」と聞いて、新たな視点を得るというオープンな質問をするのが適切かと思います。

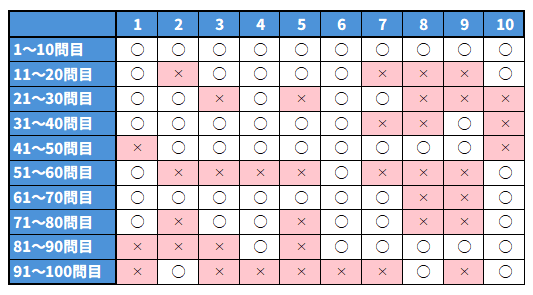

第1位 Claude(Sonnet 4.5) 92点

第1位はClaudeでした。点数も圧倒的で、品質面ではかなり信頼できる内容です。ここまでのツールと点数が大きく違うため、何か間違ったかと思いました。

点差がどうしてここまであるのか、正確な分析は難しいのですが、推論過程を見てみると、Claudeはファイルの読み込みが上手な印象があります。GeminiはCSVファイルを正確に読み取る段階で困難がありましたが、Claudeはファイルを読み込んだ後、問題集として見やすい形式に成形してから解答を生成しているような形跡が見られました。

今回読み込ませたのはCSV形式のファイルで、どうしても難しい場合にJSON形式のファイルを使いました。もしかすると、YAML形式であれば結果も違ったかもしれません。

今回検証したツールは業界のトップを一緒に走っており、ベンチマークの結果も競り合う状態ですし、本来これだけの差が出るのは不自然です。ただし、日本の法令や法務に関する内容はこれらの企業が使うベンチマークにおいて大部分を占めているわけではなく、学習データの量に差があっても結果に反映されない可能性はありえます。

製品選定に当たっては、今回の結果を直接参考にするというより、データ形式の見直しやプロンプトの試行錯誤、生成AIの適用先の検討など、さまざまな視点から評価することが重要です。場合によっては出力の正確性よりも、ユーザーの満足度を評価軸にした方が満足度の高い生成AI活用が実現できるかもしれません。

Copyright © ITmedia, Inc. All Rights Reserved.

製品カタログや技術資料、導入事例など、IT導入の課題解決に役立つ資料を簡単に入手できます。

- リチウムイオン電池も終了か 40年眠っていた、充電を爆速化する「古くて新しい電池」って?:866th Lap

- 「国家資格で食える」はもう古い? 5年分の調査で見る、AWS、セキュリティに続く“次の資格”

- AIに書かせたコードはどこが「危ない」? プロがガチ採点して分かったこと

- AIアプリ開発「Dify」って結局何がすごいの? 機能、料金、ユースケースを徹底解説

- 正規認証が悪用される? Microsoft 365の権限を奪う「デバイスコードフィッシング」とは

- PC高騰、いつまで続く? IDCアナリストに聞く値上げ時代の賢いPC調達術

- 情シスはなぜ忙殺される? 時間を奪う「計画外業務」の正体と対策

- 失敗事例から学ぶ、失敗しない「UPS」選び

- ZOZOが明かす、1年使って分かった「GitHub Copilot」のリアルな効果

- AMD初のCPUはIntelのパクリだった? それでも公認せざるを得なかった裏事情:862nd Lap