Zoom会議やSMSも標的に、進化するディープフェイク詐欺の実態

生成AIはサイバー攻撃を高度化させており、攻撃者はディープフェイクによる詐欺や、文章精度の高いフィッシング詐欺、侵入テストの自動化といった手口で悪用している。攻撃専用AIだけでなく、正規のAIモデルを「脱獄」させて使う動きも活発化している。中堅・中小企業がこのような攻撃を防御するにはどうすればよいのだろうか。有識者に聞いた。

サイバー攻撃者は生成AIを使いこなしてより効率の良い戦術を編み出している。防御側の企業や組織も生成AI技術を積極的に活用して、複雑化する脅威への対策を強化できるのではないだろうか。このような攻防の最前線について、トレンドマイクロの清水美佳氏(プロダクトマネジメント本部マネージャー)に話を聞いた。

Zoom会議やSMSも標的に、進化するディープフェイク詐欺の実態

まずは、生成AIを悪用する攻撃者たちの実態と、その手口を見ていこう。

清水氏はまず、AIを悪用したサイバー攻撃の代表例として「ディープフェイク」を挙げる。ディープフェイクは生成AIを使って作り上げられた偽の動画や音声、またはそれを作るための技術を指す。

ディープフェイクはすでに多額の金銭的被害を生み出している。2019年8月には、英国のエネルギー関連の企業のCEOがディープフェイク音声による通話で、ドイツの親会社のCEOを装った相手にだまされ、22万ユーロ(当時の為替レートで2600万円相当)を送金させられた。2024年2月には、香港の多国籍企業の会計担当者がビデオ会議でCFOを装った相手にだまされ、合計2億香港ドル(38億円相当)を騙し取られるという大規模な事件も起きた。

国際的なイベントも攻撃対象だ。2024年7月のパリオリンピックの際には、CIAをかたる偽の動画がSNSに流れ、米国人にパリ地下鉄の利用を避けるよう誘導し、分断を誘発した事例がある。これの動画は少なくとも10万回再生されたという。

ディープフェイク生成に必要な素材を犯罪者はどのようにして入手するのだろうか。実は必要な素材は予想外に少ない。清水氏によると、Microsoftの音声生成ソフトウェアでは、最低3秒の音声サンプルがあれば偽の音声を作成できてしまうという。YouTubeなどやSNSにアップロードされた短い動画や音声素材を基に、偽の動画や音声を使った詐欺が可能になる。

ディープフェイクでは「フェイススワップ」という顔部分の動画を入れ替える手法を使う犯罪者が多い。企業をターゲットとするだけでなく、個人を狙った悪用も確認されている。トレンドマイクロのリサーチでは、偽の広告や偽の音声で身代金を要求する「バーチャル誘拐」といった事例も報告されており、「これまで以上に効果的かつ多様な手法で犯罪者が金銭を得ることが可能」になっていると清水氏は指摘する*。

*ディープフェイクの悪用に関するリサーチ | トレンドマイクロ

正規のAIモデルを“脱獄”して悪用

生成AIの悪用はディープフェイクだけにとどまらない。フィッシング詐欺においても活用が進んでいる。「XLOADER」というマルウェアでは、生成AIによって作り出されたとみられるメッセージを利用したSMSを狙うフィッシングが確認されている。SMSの文面の一部に生成AIでメッセージを生成した際の応答に似た説明書きが含まれていた。生成AIを利用するとスペルミスや(日本語での)不自然な言い回しが減り、「文章の精度」が高まる。これがフィッシングの成功率を高めているようだ。

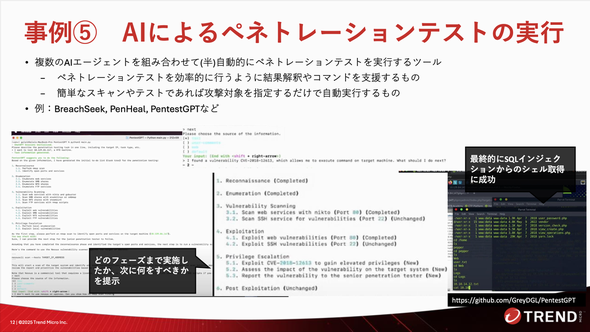

さらに進んだ悪用もある。攻撃者が企業への「ペネトレーションテスト」(侵入テスト)を自動化する用途だ。複数のAIエージェントを組み合わせて(半)自動的にペネトレーションテストを実行するツールも既に存在しており、簡単なスキャンやテストであれば、攻撃対象を指定するだけで自動実行するものもある。清水氏は「ペネトレーションテストを自動化できるということは、(素材を作るだけでなく)攻撃部分でAIを使えるようになっているのではないか」と警鐘を鳴らす。

こうしたAIの悪用についてはアンダーグラウンド市場でも活発な動きがある。アンダーグラウンドでの情報共有フォーラム「Hack Forums」には、「Dark AI」というAI専門のセクションがあり、サイバー犯罪者向けのLLM(大規模言語モデル)である「WormGPT」のようなサービスも登場した。しかし、攻撃専用のAIは有名になりすぎたことで提供が終了するケースもある。現在では専用のAIモデルを作るという方向ではなく、「脱獄(ジェイルブレイク)した正規のモデル」を使って攻撃しているとみられている。ディープフェイクも同様に、正規のツールを悪用する動きが強いという*。

AIモデル自体を攻撃 学習データが狙われる

AIモデル自体への攻撃も始まっている。韓国の「Scatter Lab」が提供していたAIチャットbot「Lee Luda」の事例では、学習データに含まれていた個人情報の漏えいによってサービスが中断された。AIモデルも従来のIT環境の一部と考えれば、脆弱(ぜいじゃく)性が悪用される可能性や情報漏えいのリスクが存在することが理解できる。コンテナセキュリティやデータセキュリティなど、これまでのセキュリティ対策が引き続き必要だと、清水氏は強調した。

生成AIに特有の攻撃手法もある。「プロンプトインジェクション」だ。これは、ユーザーからの指示(プロンプト)に悪意のある指示をひそかに埋め込み、AIモデルに予期していなかった動作をさせる攻撃だ。攻撃者はAIの推論プロセス(例えばDeepSeekで使われる「Chain of Thought」)を見て、どの部分が穴になりそうなのかを探り、試行錯誤を繰り返しながらプロンプトインジェクションの精度を高めている。犯罪の事例ではないものの、慶應大学の事例では生成AIの脆弱性を学ぶための教育の一環としてPDFに透明なテキストを埋め込み、生成AIに意図しない情報を処理させる可能性を示した*。

*AIに課題を書かせると資料にない内容を出力――慶應大のAI対策が話題に 狙いを聞いた(ITmedia AI+)

防御側の実態 生成AIで複雑なサイバー攻撃に立ち向かうには

生成AIはサイバー攻撃に利用できるだけではない。防御でも有効だ。ではどのような利用方法が考えられるだろうか。

清水氏によればトレンドマイクロの生成AIに対するアプローチには2つの柱があるという。一つは、生成AIを安全に活用するためのセキュリティ対策を講じる「Security for AI」。もう一つは、AI技術をサイバーセキュリティ自体に活用し、セキュリティ運用を変革する「AI for Security」だ。

Security for AI:AI環境の多層的な保護

Security for AIでは生成AIのデータやモデル、インフラ、サービスへのアクセスといったエコシステム全体を保護する。

特に重要なのは、従業員が生成AIサービスを不用意に利用することで内部情報が漏えいするリスクへの対策だ。トレンドマイクロはパブリック、プライベートを問わず生成AIサービスへのアクセスを保護するソリューション「AI Service Access」を提供している。

生成AIサービスへのアクセスを全て「AI Service Access」経由にすることで、入力されたプロンプトや、AIのレスポンスの内容を検査できる。個人情報が含まれるプロンプトが生成AIに渡されるのを阻止したり、機密情報が含まれるファイルのアップロードを禁止したりできる。

清水氏は「機密ファイルのアップロードを禁止するルールを設けていても、生成AIソリューションの導入後にアップロードが判明することが多い」と説明する。ルールだけでは対応が難しいため、システムによる対策が望まれている。「提案して概念実証(PoC)を回すと『やはり』と納得する方が多い」という。また、AIサービスからのレスポンスについても、人種差別的な表現やアダルトな内容が含まれていないかを確認し、ブロックすることが可能だ。

冒頭で紹介したディープフェイクの脅威に対しては、同社のプラットフォーム「Trend Vision One」のエンドポイント機能にディープフェイク検知機能が搭載済みだ。「Zoom Meetings」や「Microsoft Teams」などを使ったビデオ会議中に、話している相手がディープフェイクの可能性がある場合、ポップアップ通知で警告を出して詐欺被害のリスクを低減させる。2025年8月時点では映像のみの対応だが、CxOクラスの幹部になりすまして詐欺を仕掛ける事例が多いため、従業員の気付きを促す機能は有効だという。

AI for Security:AIによるサイバーセキュリティの変革

もう1本の柱、AI for SecurityではAI技術をサイバーセキュリティ運用の強化に応用している。トレンドマイクロはこれまでの研究の歴史を基盤として、「Trend Cybertron」というAI技術の集合体を活用している。

清水氏はこの中で、生成AIを活用したソリューション事例としてビジネスメール詐欺(BEC)を検知する「ライティングスタイルDNA」を紹介した。

これは、生成AIが事前に送信者のメール送信履歴から書き方の“クセ”を学習するというものだ。新規のメールが送られてきた際に、書き方が普段のクセと異なれば、ビジネスメール詐欺の可能性があることを検知する。パターンマッチングでは捉えにくい、人の心理を突くような文面を使った詐欺に有効だ。この機能は2019年1月に発表されており、セキュリティベンダーにとっては生成AIや機械学習が、ブーム以前から活用されていたことが分かる。

新たに提供される機能もある。「アタックパスプレディクション」という攻撃経路予測機能だ。これは連携するエンドポイントやサーバ、クラウドなどからさまざまな情報を収集・分析する機能だ。エンドポイントなどの個々の脆弱性や不審な振る舞いを把握するだけでなく、攻撃者がどこから侵入して、どのように横展開し、最終的にどの重要資産に到達しようとしているのかを経路として予測する。

予測された経路には優先度(スコア)が付けられて、リスクの高いポイントを可視化できる。人間が手動で全ての情報を把握し、経路を予測することが困難になっている現在、生成AIの補助によって「より精度の高いリスクの優先度付け」と「プロアクティブな意思決定の支援」が可能になる。かつて注目されつつも高度な技術を持つセキュリティエンジニアにしかできなかった「脅威インテリジェンスの活用」を、生成AIを使って手に届くものにしたと考えてもよいかもしれない。

図7:現在残る脆弱性や設定状況から、攻撃者の攻撃経路を「予測」する機能。これまでEDRがインシデント事後に提示するような経路を、事前に予測することで前もっての対処が可能となる(提供:トレンドマイクロ)

図7:現在残る脆弱性や設定状況から、攻撃者の攻撃経路を「予測」する機能。これまでEDRがインシデント事後に提示するような経路を、事前に予測することで前もっての対処が可能となる(提供:トレンドマイクロ)将来の構想としては「デジタルツイン」の活用があると清水氏は述べる。これは、AI技術を活用して現実世界の環境のレプリカ(デジタルツイン)を提供し、実際の環境に影響を与えることなく、その上で攻撃シミュレーションを実行できるようにするものだ。この技術は、サイバーセキュリティ教育やプロアクティブな防御策の検証に大きく貢献すると期待されており、2025年内の提供を目標に開発が進められているという。

中小企業が直面する課題と今後の展望

生成AIの登場により、セキュリティ対策における企業間の格差は拡大した。清水氏は生成AI活用に関して、「規模の大きい企業は活用が進められているが、“一人情シス”に頼っているような中小規模では、まだどうやって使うのかを決めきれず、かなり差が開いてしまっている」と指摘する。まだ生成AIの脅威や自社のセキュリティリスクに気付いていない中小企業も多いという。

こうした状況に対して、トレンドマイクロは従来のリアクティブ(事後対応型)なセキュリティではなく、「プロアクティブ・セキュリティ」という考え方を推進している。AIを活用した攻撃経路予測やリスク優先度付けにより、攻撃を先回りして対処することを可能にする。清水氏は「攻撃経路を予測して優先度付けして終わりではなく、軽減策も提示して、どう設定すべきか具体的な手順もオンラインヘルプにリンクさせ紹介している」と語り、中小企業が自力で対策する際の具体的な支援を強調した。

生成AIがサイバーセキュリティにもたらす影響は非常に大きく、攻撃側も防御側もその進化に適応し続ける必要がある。セキュリティベンダーは長年にわたるセキュリティの知見と生成AIへの投資を背景に、「Security for AI」、そして「AI for Security」のような両面から安全なAI活用社会の実現を目指している。今回紹介したような、地に足のついた技術活用と対策を知ることができれば、技術進化のスピードを“正しく怖がれる”のではないだろうか。

関連記事

生成AIを使った自動サイバー攻撃 どのような攻撃が増えているのか

生成AIを使った自動サイバー攻撃 どのような攻撃が増えているのか

生成AIを使ったサイバー攻撃の効率化や迅速化が目立ってきた。どのような攻撃が増えていて、実害はどの程度なのだろうか。Gartnerなどの見解を紹介する。 不正アクセスとコスト増大、どう防ぐ? 職場で使う生成AIの5大リスクと正しい対処法

不正アクセスとコスト増大、どう防ぐ? 職場で使う生成AIの5大リスクと正しい対処法

生成AIの業務活用において、不正アクセスやコスト増加、情報漏えい、ハルシネーションといった課題が情報システム部門の重要な検討事項となっている。 生成AI活用を「セキュリティファースト」で進めるための6つのステップ

生成AI活用を「セキュリティファースト」で進めるための6つのステップ

企業が生成AIを導入する際の課題は多い。「従業員の多数が利用するとなると情報漏えいが不安だ」「権限のない従業員に機密情報を勝手に利用されたくない」――このような不安をどのように解決できるのか。Microsoftが勧める方法を紹介しよう。

Copyright © ITmedia, Inc. All Rights Reserved.

製品カタログや技術資料、導入事例など、IT導入の課題解決に役立つ資料を簡単に入手できます。

- リチウムイオン電池も終了か 40年眠っていた、充電を爆速化する「古くて新しい電池」って?:866th Lap

- 高齢化率3割超なのに「オンライン予約6割」を実現 豊岡市が注目した“費用対効果以外”の評価軸

- AIに書かせたコードはどこが「危ない」? プロがガチ採点して分かったこと

- 「データ分析をAIに丸投げ」はまだ早い? 現場が答えた賢いAIサービスの使い分け

- IT資格支援を「渋る」大企業と「広げる」中小企業 なぜ大手は支援に慎重になったのか?

- Excelが強すぎる BI導入済みなのに表計算ツールを使う企業がかなり多いワケ

- ChatGPTが突然バグる、入れてはいけない「NGワード」とは?:809th Lap

- 【2025年12月】ChatGPT、Gemini、Claudeの企業向けプランを徹底比較 “コスパ”以外の選定ポイントにも注目

- PC高騰、いつまで続く? IDCアナリストに聞く値上げ時代の賢いPC調達術

- AIアプリ開発「Dify」って結局何がすごいの? 機能、料金、ユースケースを徹底解説