ディープラーニングを大幅短時間化「MN-1」って何?:5分で分かる最新キーワード解説(2/5 ページ)

「ChainerMN」は何が他のフレームワークと違うのか?

PFNが開発、提供しているChainerは、Pythonベースのディープラーニング向けオープンソースフレームワークであり、上記の他フレームワークと並び、複雑なニューラルネットワーク設計を行うフレームワークとして世界的に利用されているものだ。

Chainerでは、TensorFlowなどが使う「Define and Run」と呼ばれる、ネットワークを作ってから学習する手法ではない。データを順方向に流して初めてネットワークができ、その逆向きの方向で「誤差逆伝搬」と呼ばれる計算を自動で行ってパラメータを更新して学習する「Define by Run」と呼ばれる方法をとる。この方法は「コードの最適化が難しい」といわれるものの、データごとにニューラルネットを作る用途では柔軟性が高いのがメリットになるとされている。

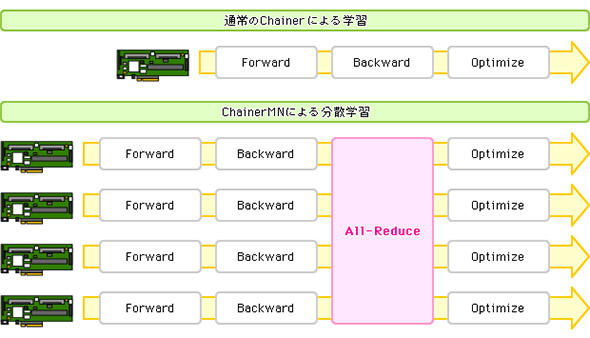

このChainerの技術を利用して、現在入手できるGPUクラスタをうまく利用するために拡張したのが「ChainerMN」であり、ChainerMNを大規模に実行するために構築されたのが「MN-1」だ。ChainerMNの処理は図4のようなイメージである。

「All-Reduce」処理により、各GPUを流れてきたデータが、一度集計されてその結果がそれぞれの流れに配られる仕組みをとる。All-Reduceには、NVIDIAのマルチGPU集合通信ライブラリであるNCCL(NVIDIA Collective Collection Library)を利用し、NCCLと相性がよい高速物理インタフェースであるInfiniBandが選ばれた。

つまり「Chainer」が持つ柔軟性に加え、大規模なGPU分散処理環境に適合する高速通信インタフェースと、分散学習を効率的に実現する仕組みを組み合わせたことで、大幅な学習の時間短縮ができたというわけだ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製品カタログや技術資料、導入事例など、IT導入の課題解決に役立つ資料を簡単に入手できます。

- リチウムイオン電池も終了か 40年眠っていた、充電を爆速化する「古くて新しい電池」って?:866th Lap

- 実際にやってみた、ソフトウェアによる「上書きデータ消去」実証レポート

- 「国家資格で食える」はもう古い? 5年分の調査で見る、AWS、セキュリティに続く“次の資格”

- AIに書かせたコードはどこが「危ない」? プロがガチ採点して分かったこと

- JAつがる弘前が2カ月で「りんご在庫管理アプリ」を内製化 盗難事件を乗り越えて業務変革を成し遂げた舞台裏

- 新たな脅威か? Windows Defenderを無力化するAIマルウェアの恐怖:839thLap

- 会社の規則は穴だらけ? 誰も守ってくれない「無視されるITルール」【実態調査】

- 「2026年は脱MySQLすべき」エンジニアたちが突然騒ぎ出したワケ:864th Lap

- 「データ分析をAIに丸投げ」はまだ早い? 現場が答えた賢いAIサービスの使い分け

- まるで聖徳太子の耳のように複数話者を聞き分ける「分離集音」技術とは?

図4 「Chainer MN」の分散学習の流れ(出典:PFN)

図4 「Chainer MN」の分散学習の流れ(出典:PFN)